内容

Ⅰ, 分散分析

Ⅱ, 要因・水準

Ⅲ, 結果の見方

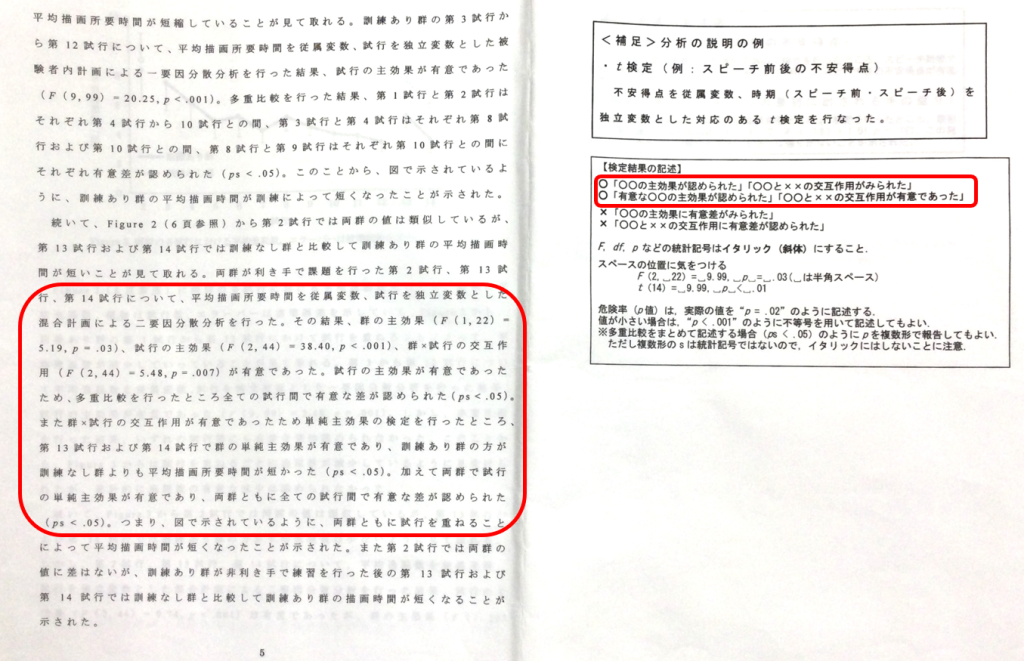

Ⅳ, 結果の書き方

Ⅵ, 用語

=======================================================================

【ざっくり】

・t検定:2つを比較

・分散分析:3つ以上を比較

【種類】

1, ~要因

・1要因:大学(A, B, C) × テスト得点

・2要因:時間帯(午前, 午後) × ご飯(白米, パン, 麺)

・3要因:旅行先(北海道, 沖縄, 所沢) × 移動手段(自転車, 徒歩) × 旅行日(平日, 休日)

*水準:大学(A, B, C) →3水準, 時間帯(午前, 午後) →2水準

2, ~計画

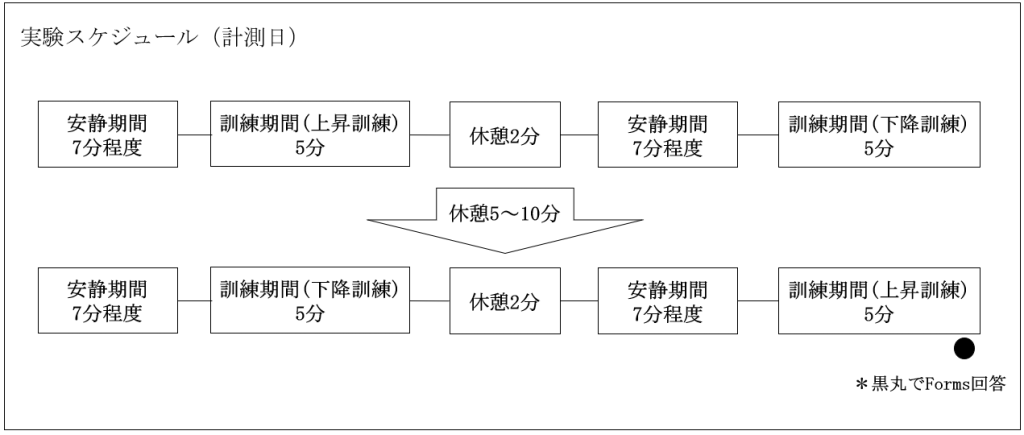

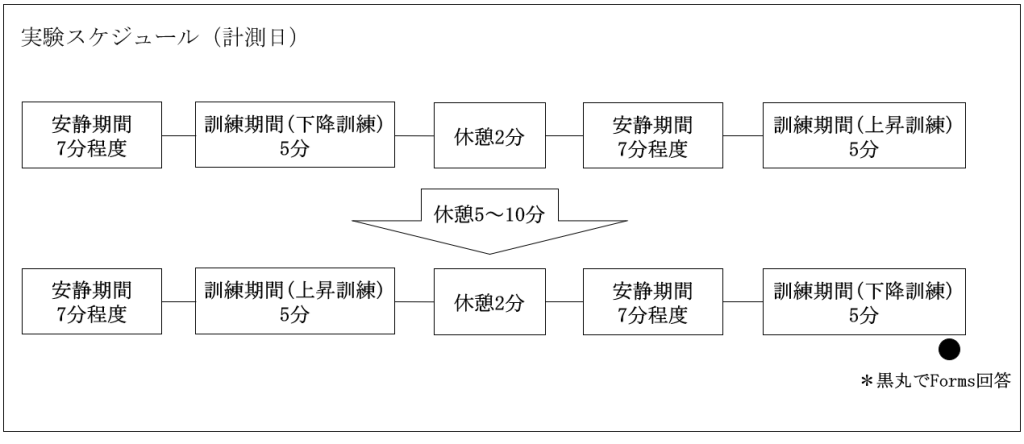

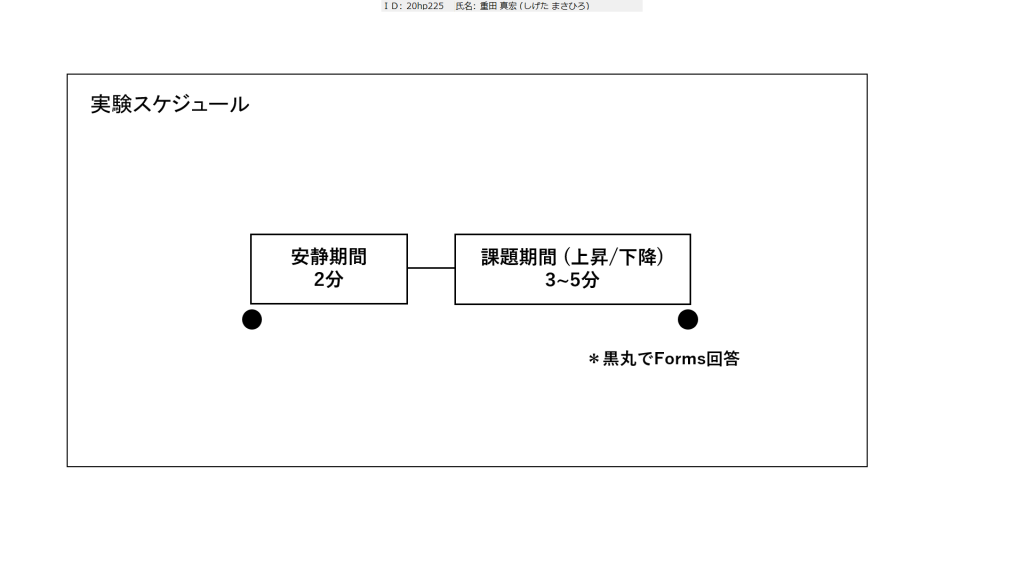

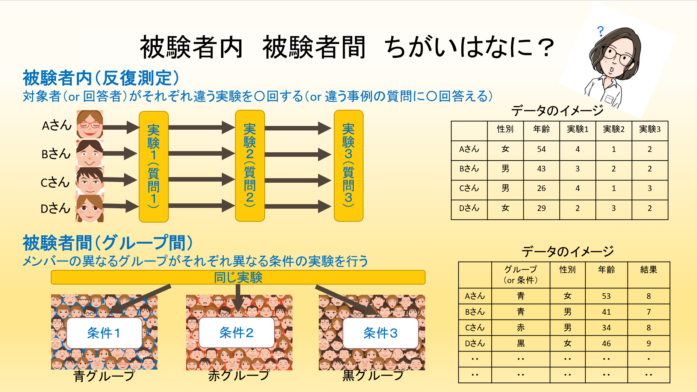

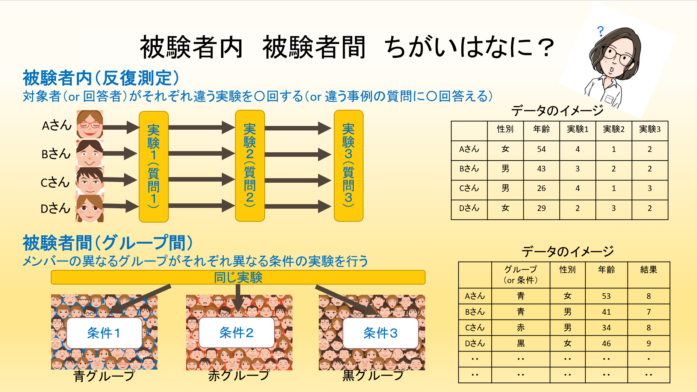

・対応あり:共通。カウンターバランス 例) 「前安静→課題→後安静」3期間

・対応なし:片方に所属。群分け。 例) 性別, 大学差など

・混合計画:対応あり+対応なし 例) 「室内の温度(温/寒) × コーヒー(3種)」

*「対応あり=参加者内」「対応なし=参加者間」

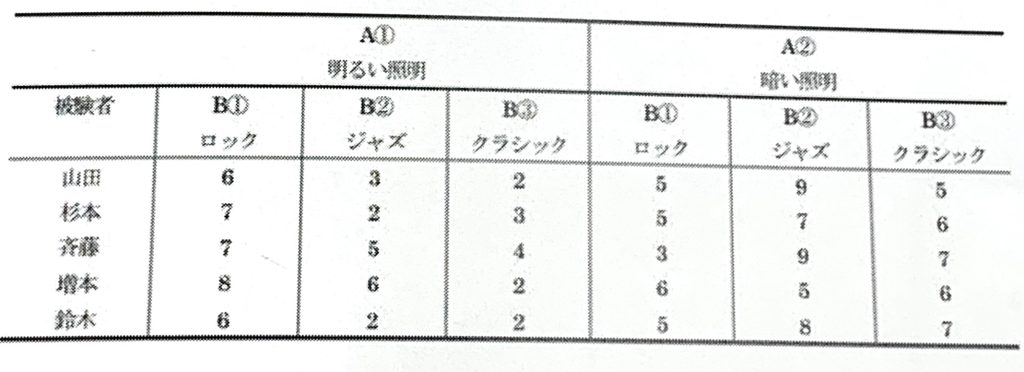

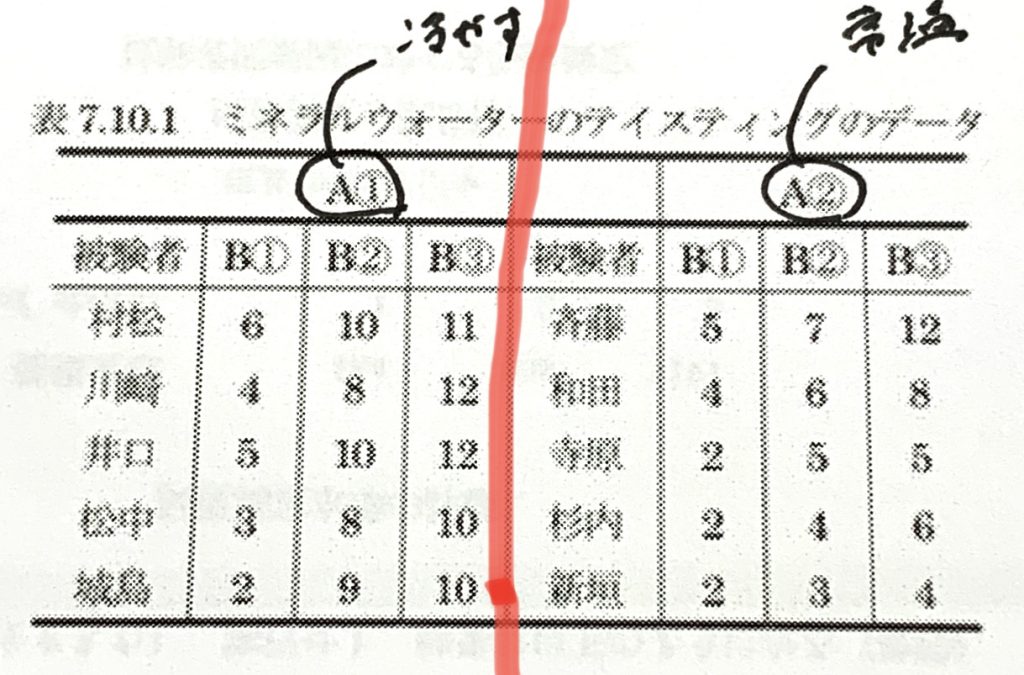

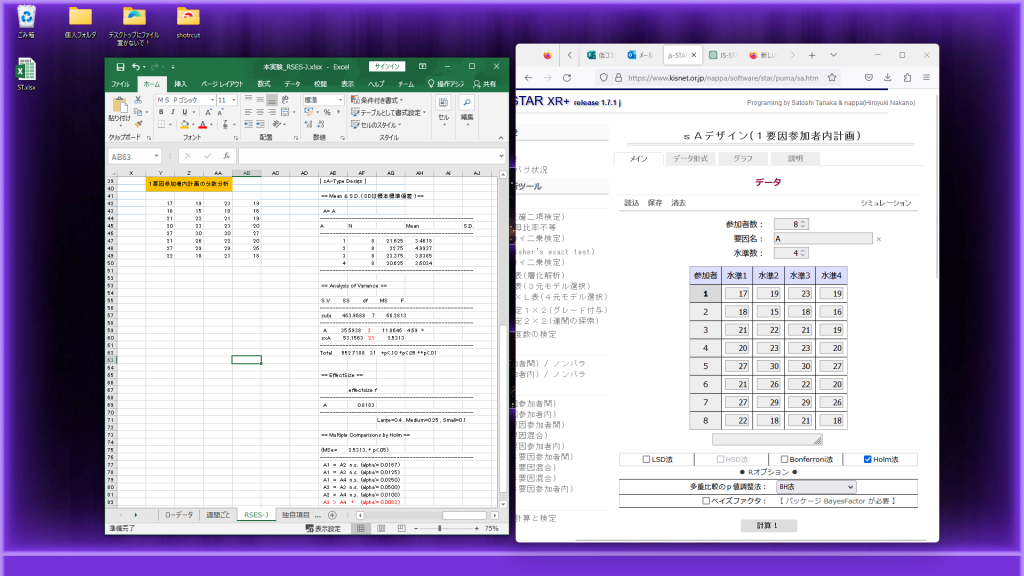

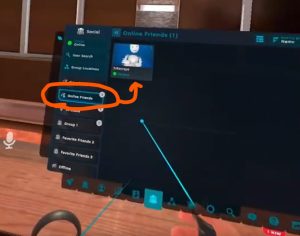

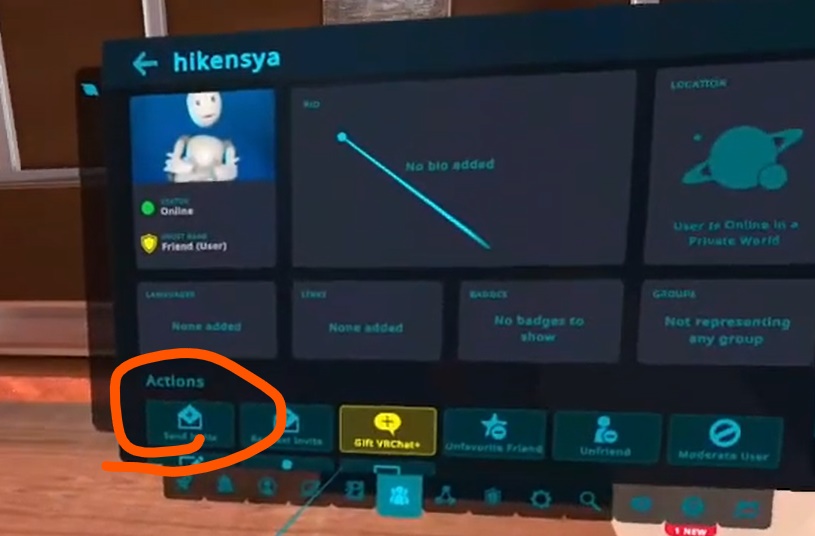

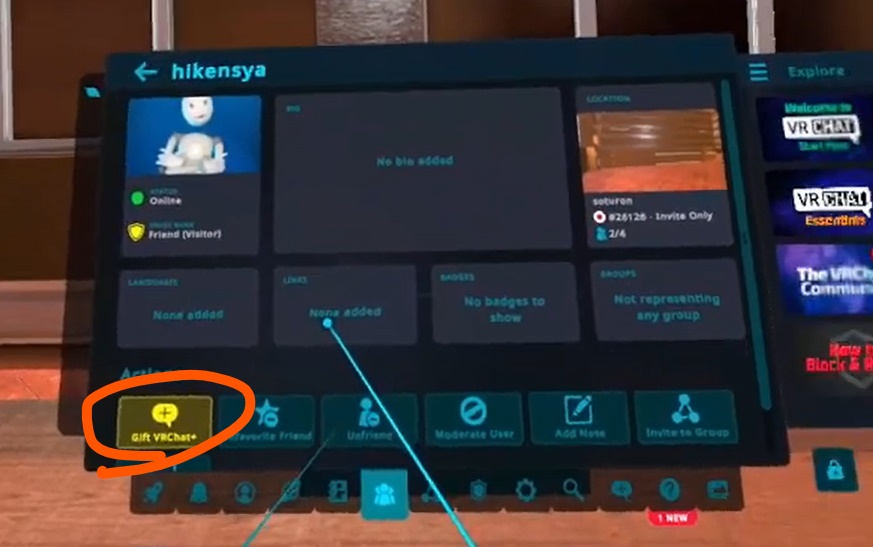

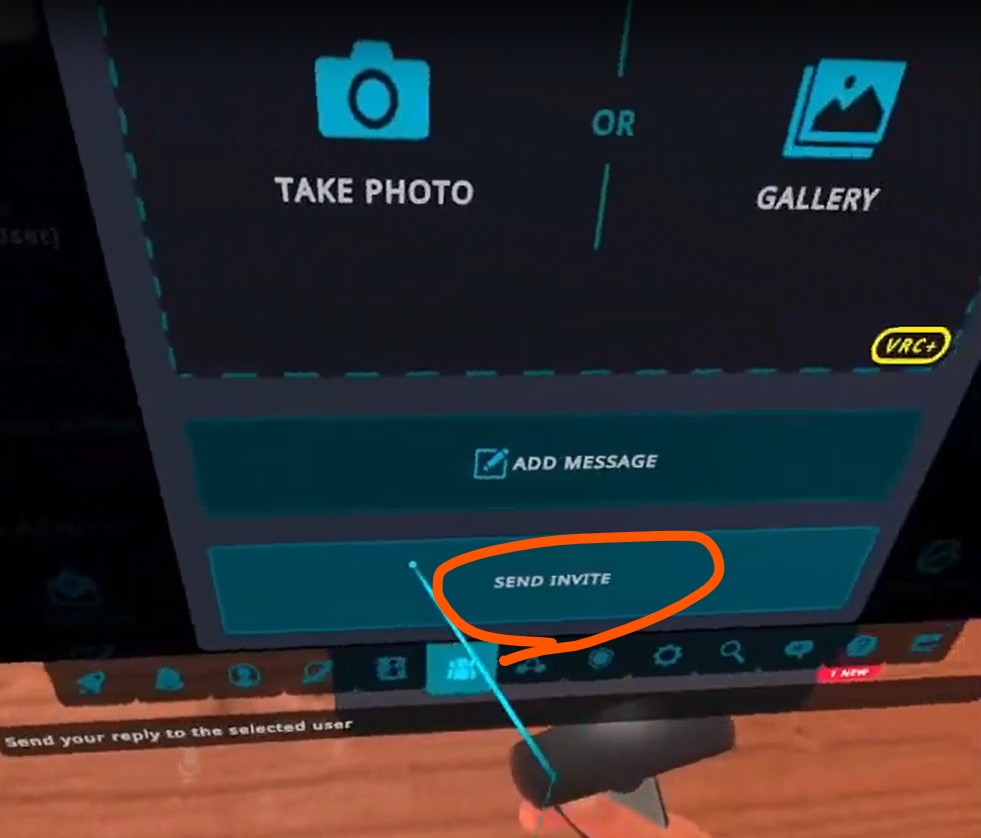

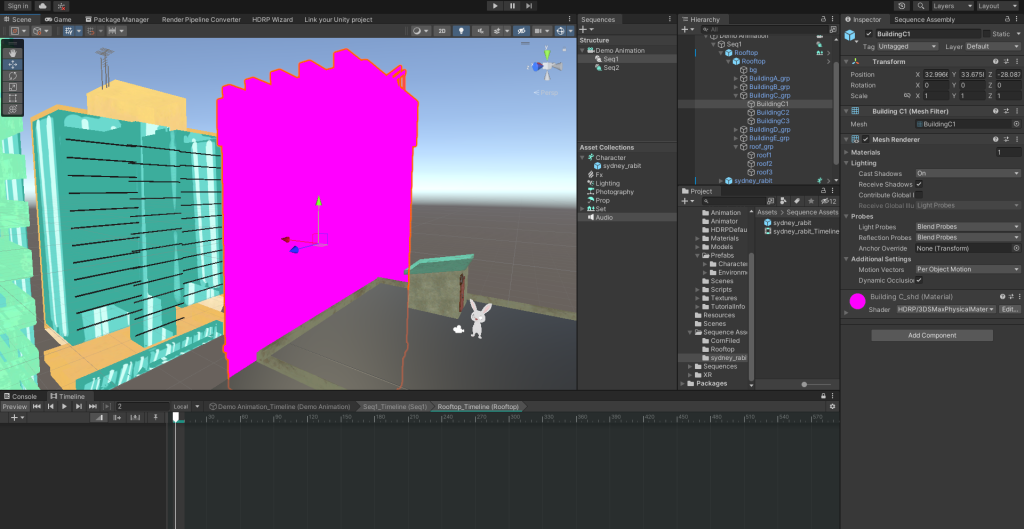

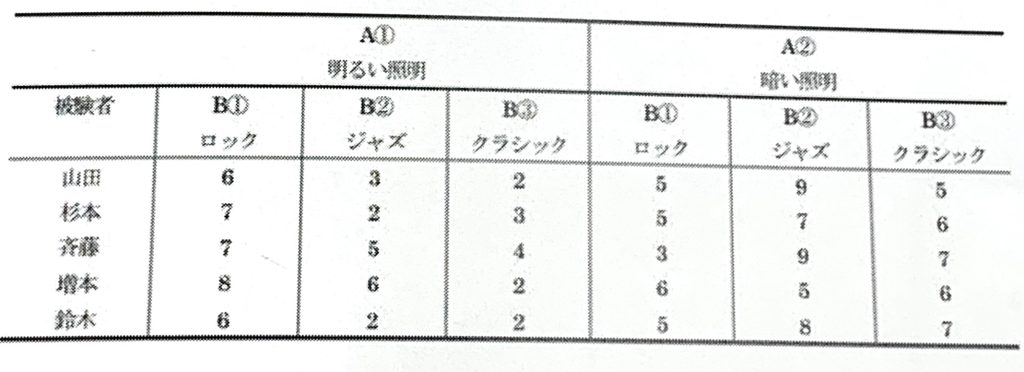

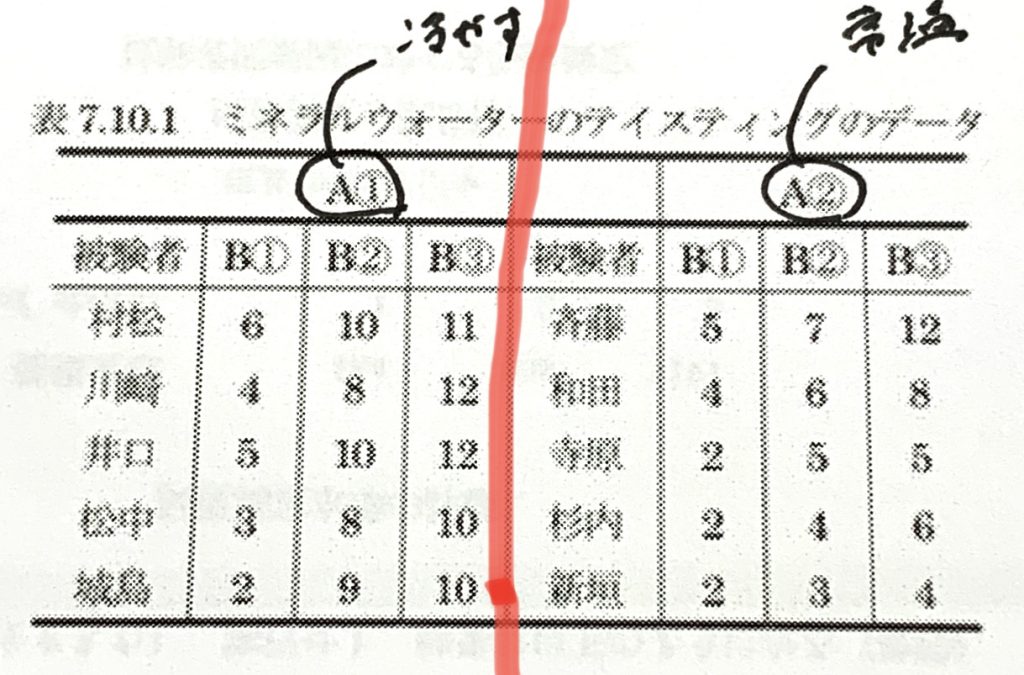

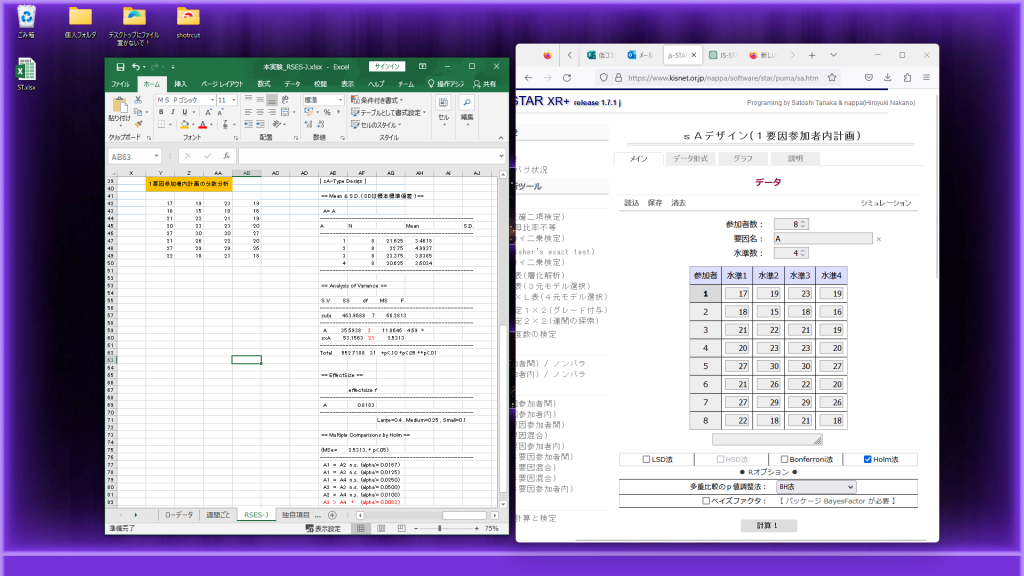

←2要因3水準参加者内計画 2要因3水準混合計画→

【結果の見方】

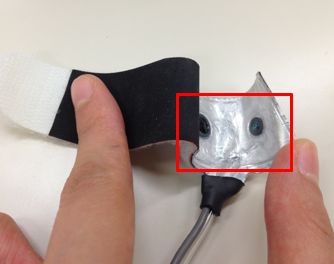

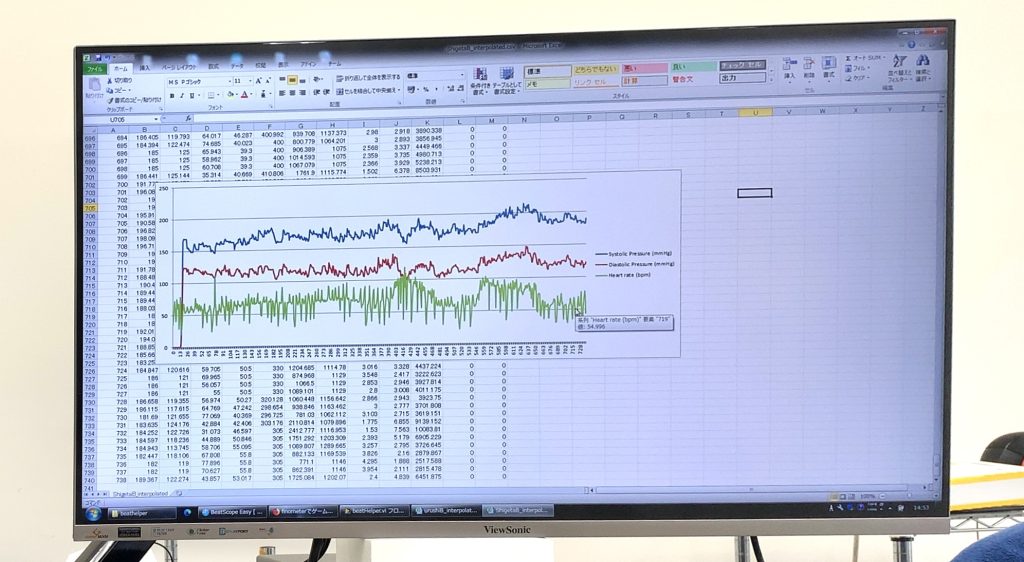

例)「衝突前後 (衝突前・衝突後) × 試行数(1~5試行)」の発汗量

・独立変数:衝突前後, 試行数

・従属変数:発汗量

1, ざっくりと分析(主効果, 交互作用)

・主効果:「衝突前後と発汗量」「試行数と発汗量」各々で関連はあるのか

・交互作用:「衝突前後×試行数」が発汗量に与える影響

参照: https://www.business-research-lab.com/220606/

2, 細かく見る(多重比較, 単純主効果)

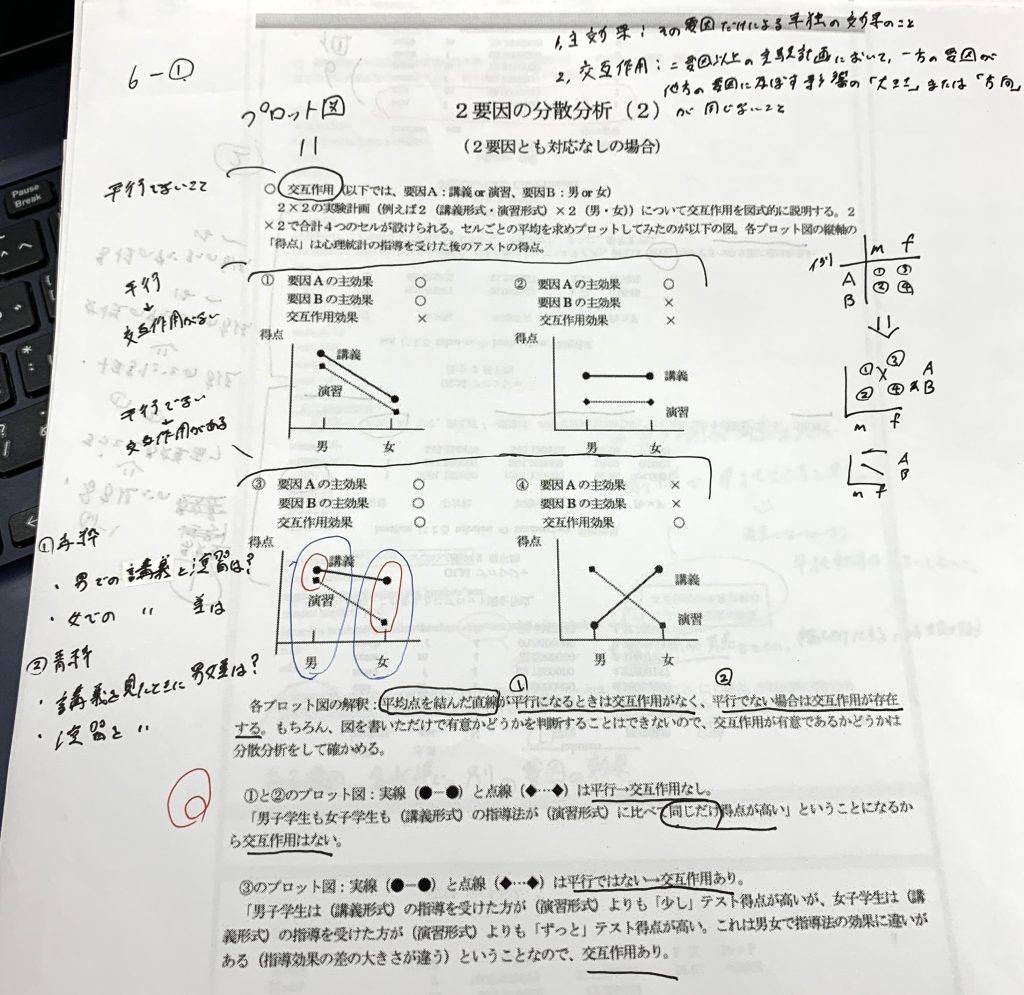

・多重比較:主効果が認められた場合のみ、「衝突前×1試行, 2試行…5試行」「衝突後×1試行, 2試行…5試行」どの組み合わせが有意かみる。

・単純主効果:交互作用が認められた場合かつ、2要因の交互作用が有意であった場合に行う。

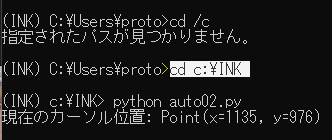

【結果の書き方】

・有意差なし (n.s.)

→「F(4, 5)=0.72, n.s.」で終わり

・有意差あり (p<.01 p<.05)

→①主効果・交互作用:「F(4, 5)=0.72, p<.01」

→②多重比較を行いどの組み合わせが有意かみる

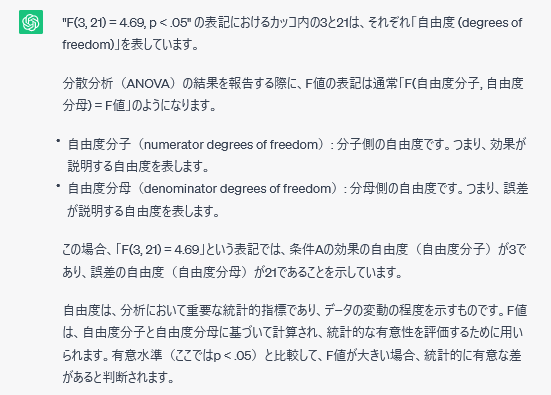

F(自由度分子, 自由度の分母)=F値, P値

【用語】

・主効果:「結果の見方1」ざっくりと分析して、結果が有意だった時に使う。

→例)衝突前後で有意:「衝突前後の主効果が認められた」

・多重比較:「結果の見方2」細かく分析して、主効果が認められた時に使う。

→例)衝突前×1試行目で有意:「主効果が有意だったため、多重比較を行った結果1試行目で有意差が認められた」

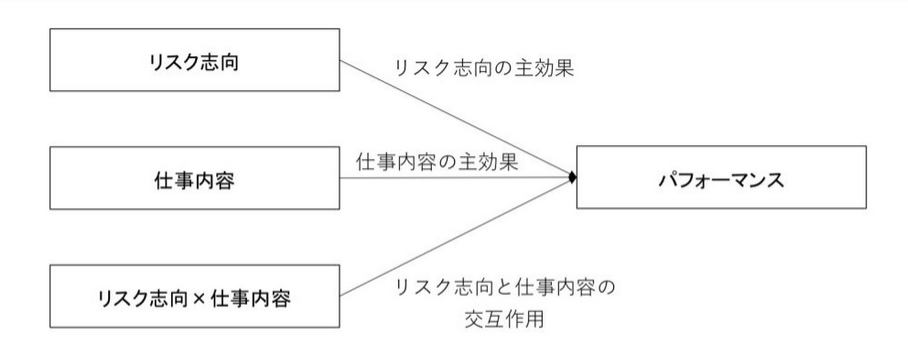

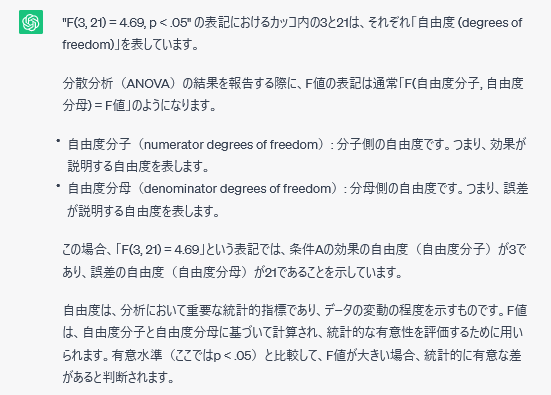

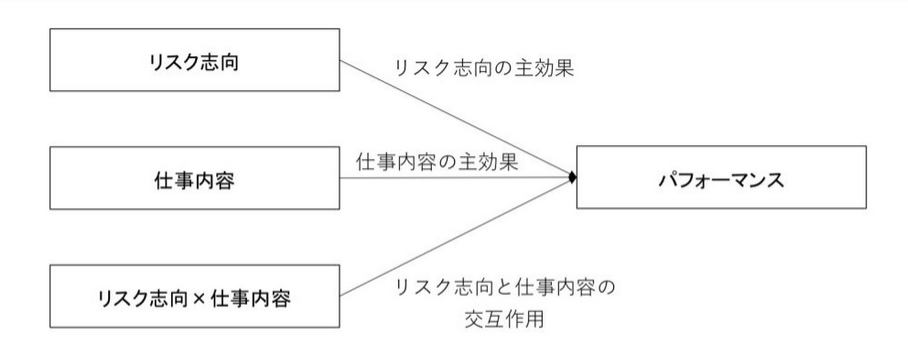

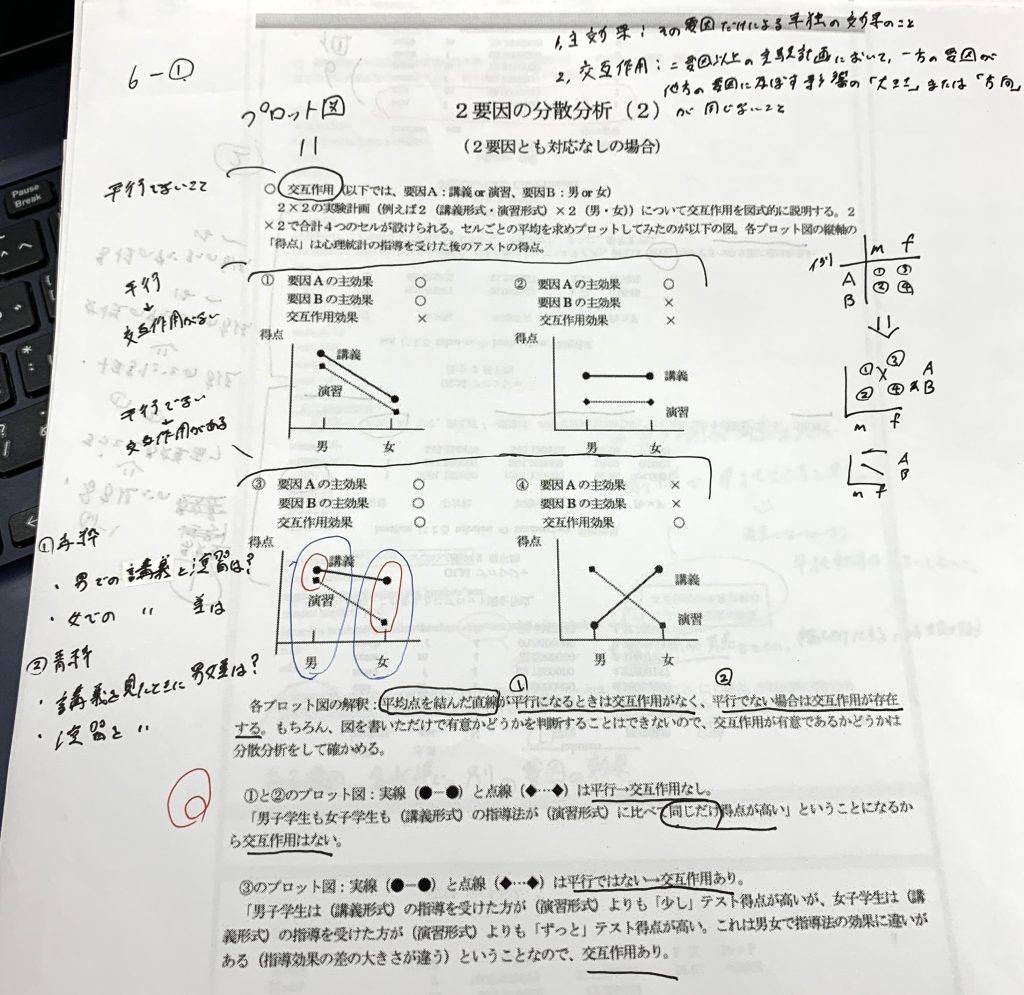

・交互作用:下の図のようにクロスで分析する。

→例)「パフォーマンス(高)×リスク志向(低)」

・単純主効果:交互作用が有意であった場合に行う

交互作用のプロット図

「平行でないもの・クロスしているもの」が交互作用が認められる。反対に平行なものは上記画像(上段)の通り交互作用が認めらない。

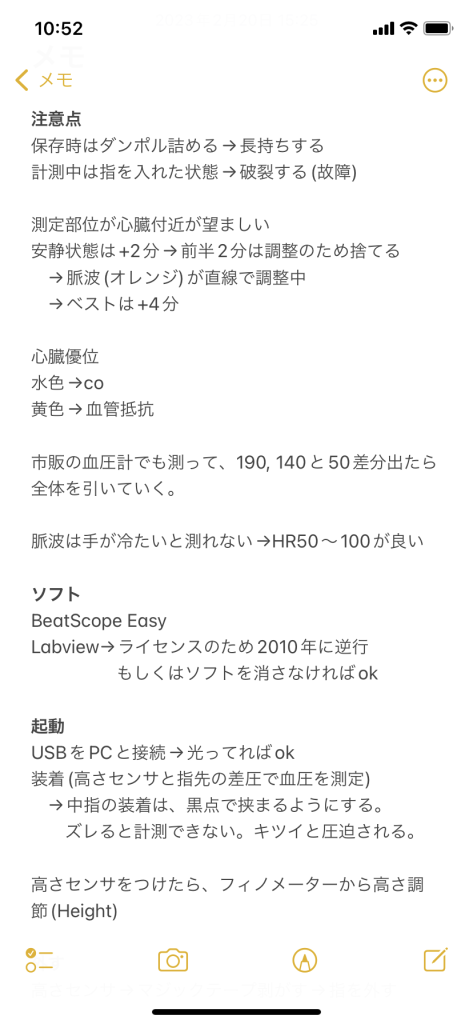

【注意点】

分散分析自体かなり複雑なため、レポートに書くときは丁寧に書く。

・分散分析:「A(~, ~)×B(~, ~)の ~要因~水準の~計画を行った」

・多重比較:「~法(Holm, Bonferroni法など)による多重比較を行った」

=========================================================================

一連の分析の流れは、例題と共にこちらのサイトで紹介されていた。統計ソフトはSPSSっぽいが、用語の説明など詳しく書かれていた。

t検定は省くとして, 重回帰分析は微妙だが因子分析なら教えられそう…