11月14日(木)

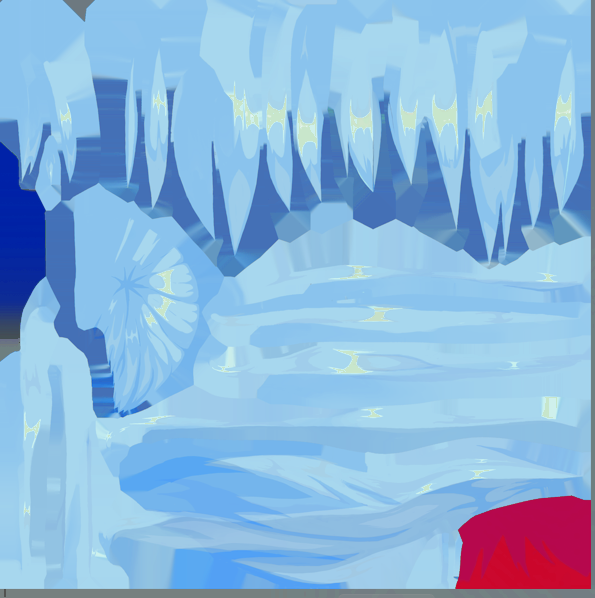

同じVRMアバターを2人使用するため、判別できるように片方の色を変更しました。 初音ミクのテクスチャーをGIMP内にて色彩変更を行いました。完成したのが下にある画像のものです。左が変更前で右が変更後です。雪ミクのような色合いになるように調整してみました。

上記の載っている画像(左が髪のテクスチャー、右が服や目のテクスチャー)が変更後に使用した画像です。

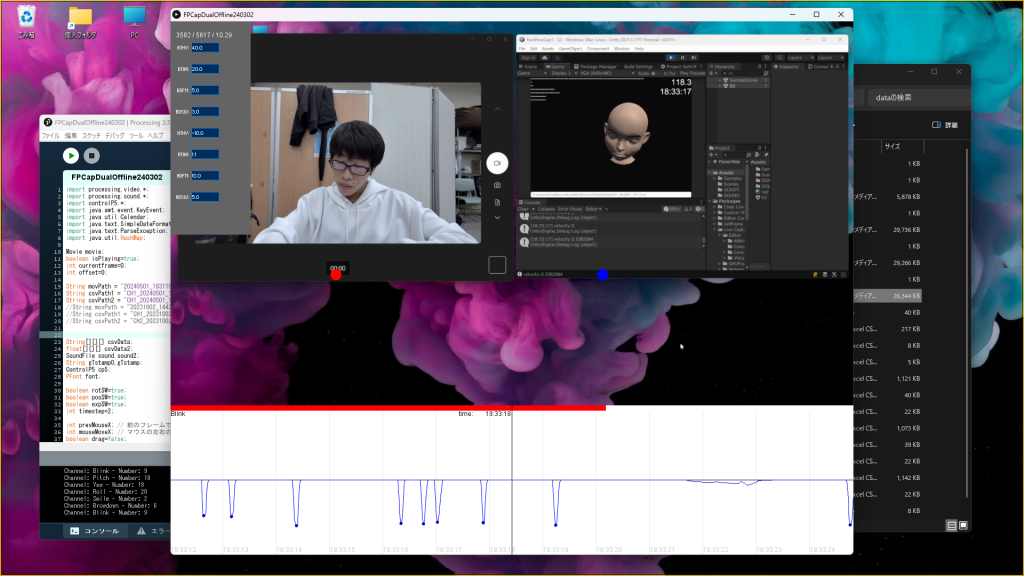

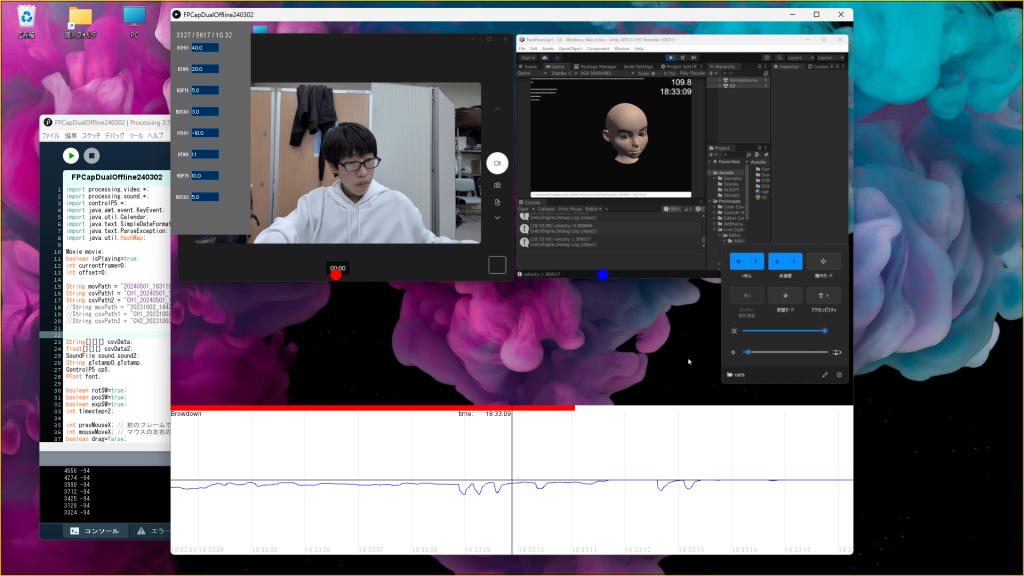

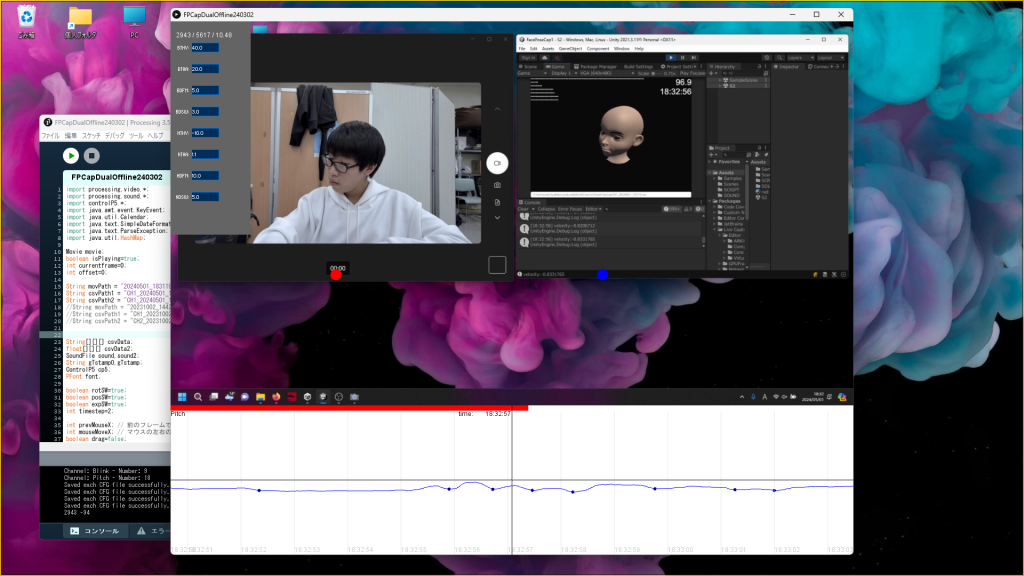

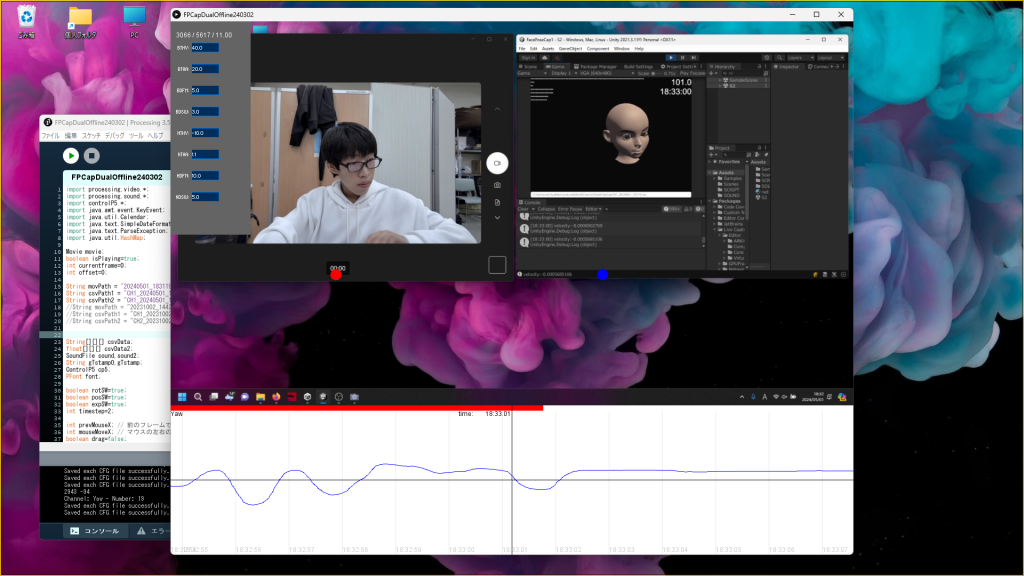

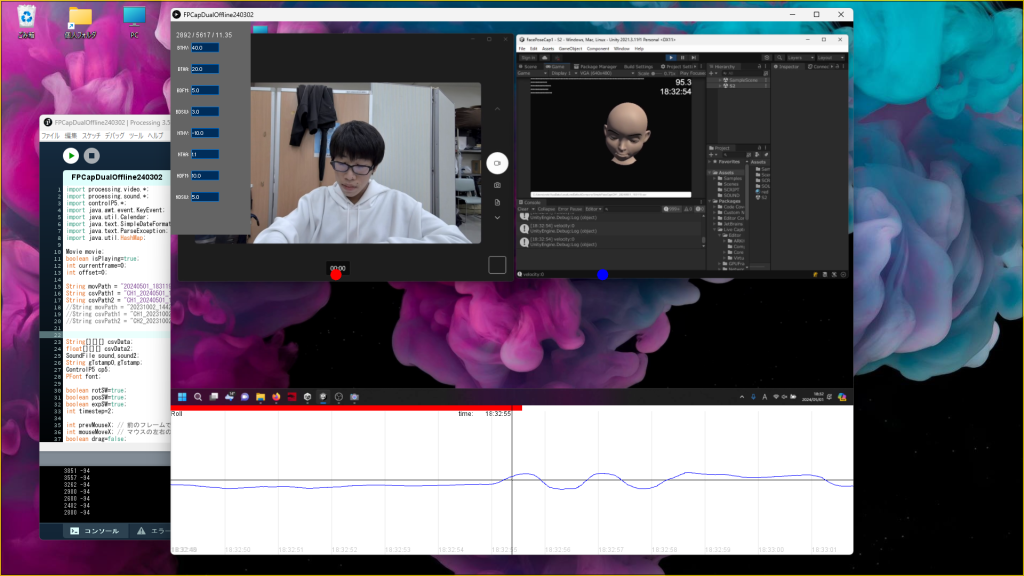

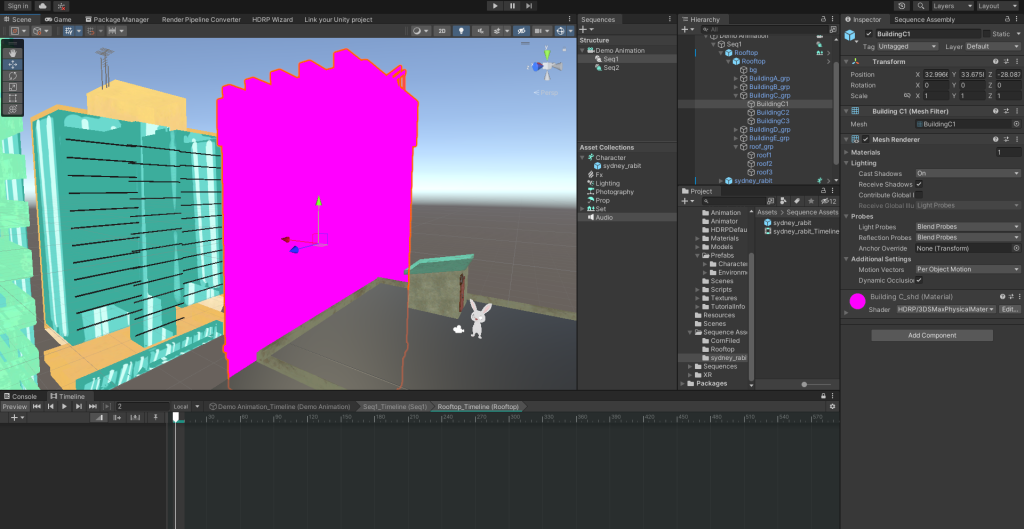

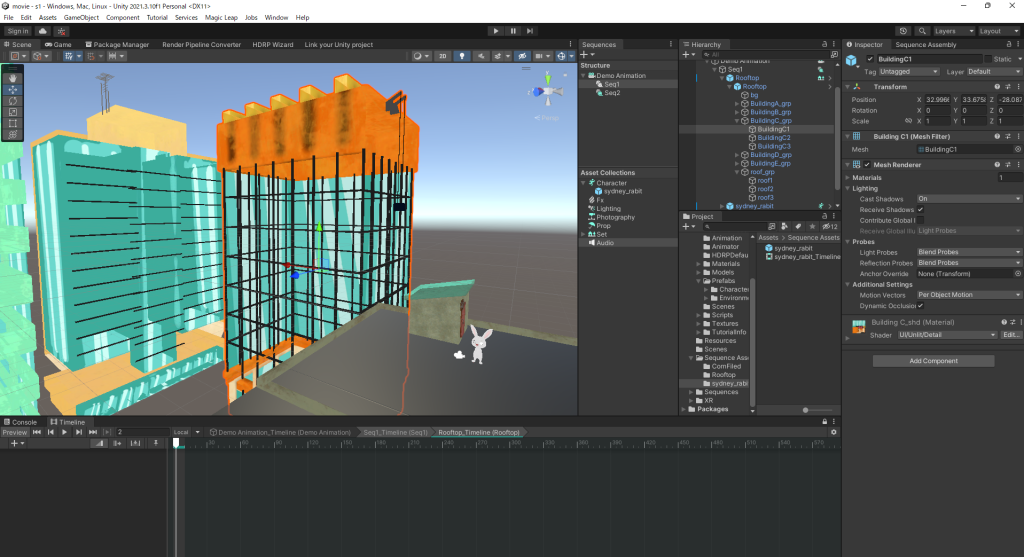

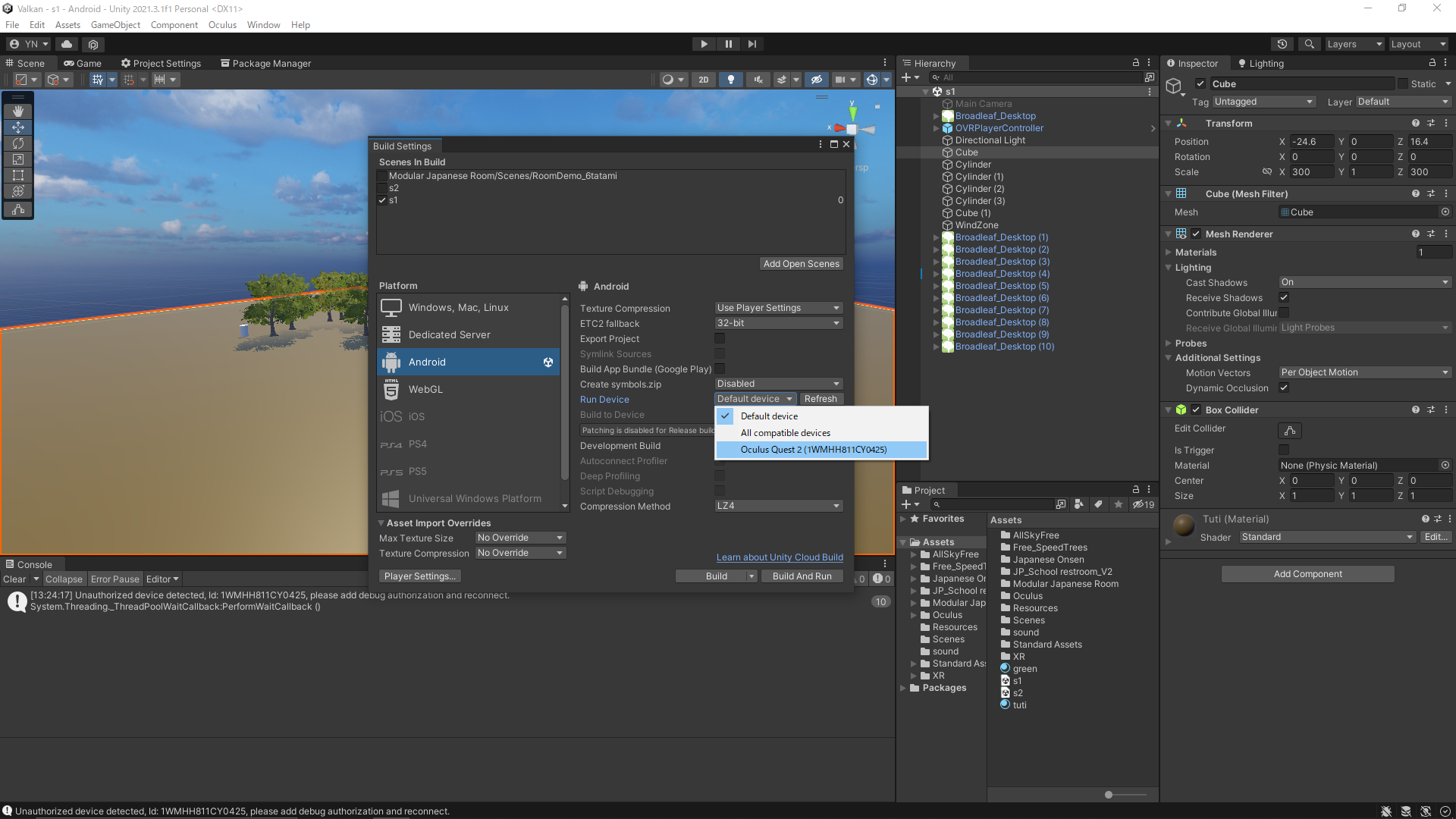

次にTimelineにてアバターの動きと音源を合わせてみました。

僅かなズレはありますが、細かい調節は後日行います。

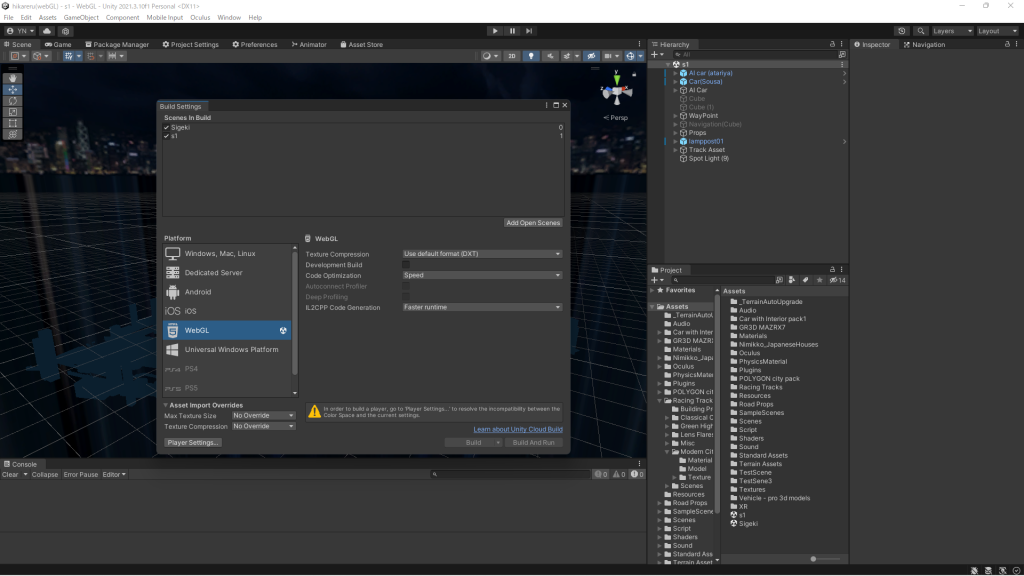

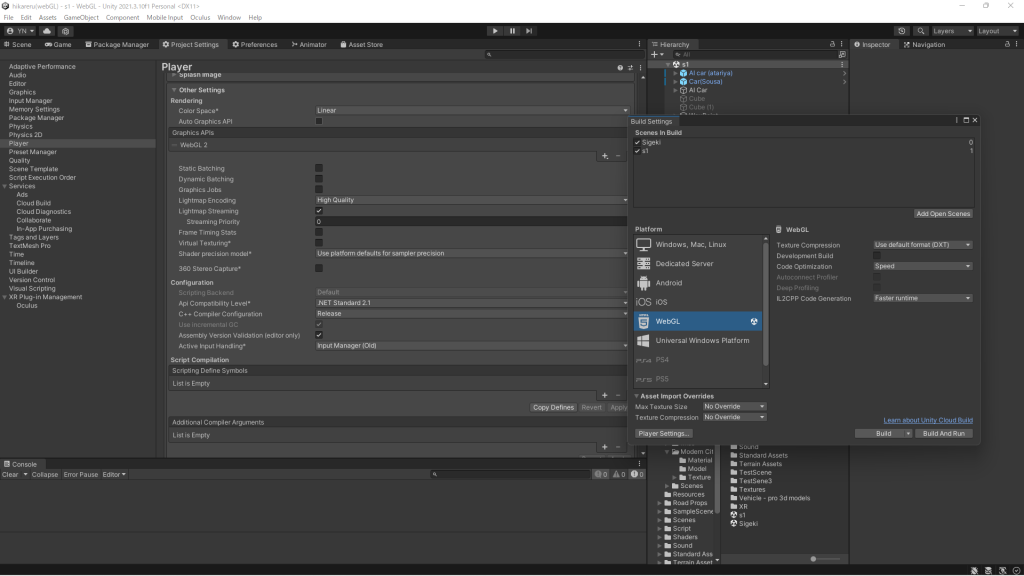

次はライブの時間を昼にするか夜にするか決め、空の調節をします。